Podcast de Eduardo Collado

Eduardo Collado

Programas de 15 minutos diarios en los que hablamos de hosting, redes y desarrollo.

- 30 minutes 34 secondsConfiguración de Puertos en Switches Cisco Nexus

Puerto de Acceso o Puerto Trunk

En un switch Nexus, los puertos pueden configurarse como puertos de acceso o como puertos trunk, según lo que se requiera en la red.

Puertos de Acceso

Los puertos de acceso se utilizan para conectar dispositivos finales, como ordenadores, impresoras y otros dispositivos de usuario final, a la red. Cada puerto de acceso está asociado con una sola VLAN.

Configuración de un puerto de acceso:

interface Ethernet1/1 switchport mode access switchport access vlan 10En este ejemplo, configuramos el puerto Ethernet1/1 como un puerto de acceso y lo asignamos a la VLAN 10.

Puertos Trunk

Los puertos trunk se usan para transportar tráfico de múltiples VLAN entre switches o entre un switch y un router. Los puertos trunk etiquetan las tramas Ethernet con un identificador de VLAN para asegurar que el tráfico se dirija a la VLAN correcta. Configuración de un puerto trunk:

interface Ethernet1/2 switchport mode trunk switchport trunk allowed vlan 10,20,30 switchport trunk native vlan 1En este ejemplo, configuraremos el puerto Ethernet1/2 como un puerto trunk para permitir el tráfico de las VLAN 10, 20 y 30, con la VLAN nativa configurada en 1. La VLAN nativa se utiliza para el tráfico no etiquetado.

Lidiar con Spanning Tree

Para proteger la red de problemas relacionados con el Spanning Tree Protocol (STP), hay que mantener la estabilidad y evitar bucles de red. Aquí os dejo las mejores prácticas y configuraciones de STP para un switch Cisco Nexus:

Configurar BPDU Guard

BPDU Guard se utiliza para proteger los puertos configurados como puertos de acceso (edge ports) que no deberían recibir Bridge Protocol Data Units (BPDUs). Si un puerto con BPDU Guard habilitado recibe un BPDU, el puerto se deshabilitará automáticamente para prevenir bucles de STP.

switch# configure terminal switch(config)# interface range Ethernet1/1 - 24 switch(config-if-range)# spanning-tree port type edge switch(config-if-range)# spanning-tree bpduguard enablespanning-tree port type edge: Configura el puerto como un puerto de acceso, lo que significa que se transicionará inmediatamente al estado forwarding.

spanning-tree bpduguard enable: Habilita BPDU Guard para deshabilitar el puerto si se recibe un BPDU.Configurar Root Guard

Root Guard previene que dispositivos no autorizados se conviertan en el root bridge, lo cual podría alterar la topología STP de la red.

switch# configure terminal switch(config)# interface Ethernet1/25 switch(config-if)# spanning-tree guard rootspanning-tree guard root: Habilita Root Guard en el puerto para asegurarse de que no se pueda convertir en root port si se reciben BPDUs de un dispositivo no autorizado.

Configurar Loop Guard

Loop Guard ayuda a prevenir bucles causados por un fallo en recibir BPDUs en puertos no-designados. Es útil en topologías redundantes donde los puertos pueden quedarse en estado «stuck in blocking».

switch# configure terminal switch(config)# interface Ethernet1/26 switch(config-if)# spanning-tree guard loopspanning-tree guard loop: Habilita Loop Guard en el puerto para evitar que se transicione a forwarding si deja de recibir BPDUs.

Configurar UDLD (Unidirectional Link Detection)

UDLD detecta enlaces unidireccionales causados por fallos físicos y puede deshabilitar el puerto afectado.

switch# configure terminal switch(config)# interface Ethernet1/27 switch(config-if)# udld port aggressiveudld port aggressive: Configura UDLD en modo agresivo para detectar y deshabilitar rápidamente enlaces unidireccionales.

Configurar PortFast

PortFast se utiliza en puertos de acceso para que transicionen inmediatamente al estado forwarding, lo que es útil en puertos conectados a hosts.

switch# configure terminal switch(config)# interface range Ethernet1/1 - 24 switch(config-if-range)# spanning-tree port type edgespanning-tree port type edge: Habilita PortFast en los puertos de acceso para minimizar el tiempo de convergencia.

Ejemplo Completo de Configuración

switch# configure terminal switch(config)# interface Ethernet1/1 - 24 switch(config-if-range)# spanning-tree port type edge switch(config-if-range)# spanning-tree bpduguard enable switch(config)# interface Ethernet1/25 switch(config-if)# spanning-tree guard root switch(config)# interface Ethernet1/26 switch(config-if)# spanning-tree guard loop switch(config)# interface Ethernet1/27 switch(config-if)# udld port aggressive switch(config)# exitConfigurar correctamente los puertos de un switch Cisco Nexus para protegernos de problemas con el Spanning Tree Protocol (STP) implica habilitar BPDU Guard, Root Guard, Loop Guard y PortFast en los puertos adecuados. Estas configuraciones previenen bucles de red, aseguran la estabilidad de la topología STP y mejoran la eficiencia de la red.

Port Security

Configurar Port Security de manera efectiva en una red corporativa es esencial para prevenir accesos no autorizados y proteger la integridad de la red. Aquí están las mejores prácticas para lograrlo en switches Cisco Nexus:

Lo primero será habilitar el feature de port-security:

switch# configure terminal switch(config)# feature port-securityDefinir Políticas de Seguridad Claras

Antes de configurar Port Security, es crucial definir políticas claras que establezcan qué dispositivos están permitidos en la red y cuáles no. Estas políticas deben ser comunicadas y aplicadas consistentemente.

Configurar Port Security Básico

Comienza con una configuración básica de Port Security para restringir el número de direcciones MAC permitidas en cada puerto:

switch# configure terminal switch(config)# interface Ethernet1/1 switch(config-if)# switchport mode access switch(config-if)# switchport port-security switch(config-if)# switchport port-security maximum 2 switch(config-if)# switchport port-security violation restrictswitchport port-security maximum 2: Permite un máximo de dos direcciones MAC en el puerto.

switchport port-security violation restrict: En caso de una violación, el puerto restringirá el acceso en lugar de deshabilitarse completamente, permitiendo al administrador investigar sin una interrupción total.Usar Sticky MAC Addresses

Configura direcciones MAC «sticky» para que las direcciones aprendidas dinámicamente se guarden en la configuración de running, lo que facilita la administración:

switch(config-if)# switchport port-security mac-address stickyImplementar Políticas de Violación

Define qué acción tomar en caso de una violación de seguridad. Las opciones incluyen protect, restrict, y shutdown. La opción restrict es generalmente recomendada para evitar interrupciones totales:

switch(config-if)# switchport port-security violation restrict- Protect: Descarta paquetes no autorizados, sin alertas ni registros. (No funciona en todos los modelos)

- Restrict: Descarta paquetes no autorizados, con alertas y registros.

- Shutdown: Deshabilita el puerto completamente en caso de violación.

Control de Macs

Control Manual

switch(config-if)# switchport port-security mac-address 0AC3.4C16.BEF0 vlan 111 switch(config-if)# switchport port-security mac-address 12B7.364D.D307 vlan 111Control con macs sticky

switch(config-if)# switchport port-security mac-address stickyPara ver las macs sticky aprendidas:

switch#sh port-security addressPara borrar una mac sticky

switch(config-if)# no switchport port-security mac-address sticky 0011.2233.4455Configura alertas para ser notificado en caso de violaciones de seguridad. Utiliza Syslog o SNMP traps para recibir notificaciones:

Monitorización y Alertas

Configura alertas para ser notificado en caso de violaciones de seguridad. Utiliza Syslog o SNMP traps para recibir notificaciones:

switch(config)# logging host <IP_del_servidor_syslog> switch(config)# snmp-server enable traps port-securityAuditoría

Realiza auditorías de las configuraciones de Port Security y las direcciones MAC asociadas a cada puerto. Utiliza comandos como:

switch# show port-security interface Ethernet1/1 switch# show port-security addressDocumentación y Formación

Documenta todas las configuraciones y asegúrate de que el equipo de IT esté formado en cómo configurar y monitorizar Port Security. Incluye procedimientos para resolver violaciones y restaurar la normalidad.

20 May 2024, 6:16 pm - 41 minutes 7 secondsProxmox

Hoy vamos a hablar un poco sobre Proxmox, porque es la mejor opción que hay ahora mismo para tener una plataforma de virtualización.

En el audio de hoy hablo de:

- Almacenamiento

- Red

- Firewall

- HA

Espero que os resulte interesante y recordad que si necesitáis algo con Proxmox en Tecnocrática es una de las cosas que hacemos.

10 May 2024, 9:49 am - 48 minutes 16 secondsUltraEthernet

En el audio de hoy os traigo la charla que di en el último EsNOG, os hablo desde los conceptos fundamentales de DMA (Acceso Directo a Memoria), que permite que ciertos componentes de hardware accedan a la memoria sin la intervención de la CPU, hasta tecnologías avanzadas como UltraEthernet, diseñadas para mejorar la eficiencia y el rendimiento en aplicaciones de Inteligencia Artificial (IA) y Computación de Alto Rendimiento (HPC).

La evolución hacia RDMA (Acceso Directo a Memoria Remota) es notable por su capacidad de eliminar copias de datos innecesarias, reduciendo la carga en la CPU y disminuyendo la latencia de la red. RDMA permite transferencias de memoria a memoria sin la intervención del sistema operativo, mejorando significativamente la eficiencia en la transferencia de datos entre sistemas remotos.

Una tecnología particularmente relevante mencionada en el documento es RoCE (RDMA over Converged Ethernet), que adapta RDMA para operar sobre redes Ethernet. RoCE mejora la eficiencia operativa al permitir transferencias de datos de alta velocidad sin sobrecargar el procesador central y es ideal para entornos como centros de datos y la nube, donde se requieren altas tasas de transferencia de datos y baja latencia.

RoCE viene en varias versiones, como RoCE v1, que opera en redes sin pérdidas utilizando Control de Flujo por Prioridad (PFC), y RoCE v2, que funciona sobre redes IP y utiliza UDP para encapsular paquetes RDMA, incluyendo mecanismos de control de congestión avanzados como ECN.

La culminación de estas tecnologías se presenta con UltraEthernet, que se describe como una evolución de RoCE diseñada específicamente para las necesidades de la IA y la HPC. Ofrece mejoras en escalabilidad, manejo de la congestión, rendimiento y seguridad, optimizando para operaciones rápidas necesarias en el procesamiento de grandes volúmenes de datos en tiempo real o tiempos de ejecución aceptables. También incorpora mecanismos de seguridad directamente en la capa de red para proteger datos críticos, como el cifrado de datos en tránsito y la autenticación de nodos.

En resumen, estas tecnologías no solo avanzan en la eficiencia y el rendimiento de las redes y los sistemas de procesamiento de datos, sino que también abordan desafíos críticos de seguridad y escalabilidad necesarios para el futuro de la computación en IA y HPC.

Descargar: ultraethernet_esnog_31.pdf

2 May 2024, 2:58 pm - 56 minutes 36 secondsLos ataques más conocidos en ciberseguridad

- Phishing: Ataque que engaña a los usuarios para obtener información confidencial, presentándose como una entidad confiable. Se subdivide en:

- Whale Phishing (Whaling): Dirigido a individuos de alto perfil para obtener información valiosa.

- Spear Phishing: Ataques personalizados basados en investigación sobre las víctimas.

- Pharming: Redirige a usuarios a sitios fraudulentos, manipulando la infraestructura de red.

- SQL Injection Threat: Explota vulnerabilidades en aplicaciones web que interactúan con bases de datos, permitiendo al atacante realizar acciones maliciosas como bypass de autenticación y exfiltración de datos.

- Cross-Site Scripting (XSS): Vulnerabilidad en aplicaciones web que permite inyectar scripts maliciosos, que pueden robar cookies, manipular contenido web, o ejecutar acciones maliciosas.

- AI-Powered Attacks: Utiliza inteligencia artificial para mejorar la efectividad, velocidad y escala de los ataques cibernéticos, incluyendo evasión de detección, phishing automatizado, y análisis de vulnerabilidades.

- Eavesdropping Attack: Captura y escucha clandestinamente las comunicaciones privadas, a través de técnicas como sniffing de paquetes y ataques Man-in-the-Middle (MitM).

- Man-in-the-Middle Attack (MitM): El atacante intercepta y potencialmente altera la comunicación entre dos partes sin su conocimiento.

- Distributed Denial of Service Attack (DDoS): Utiliza múltiples sistemas comprometidos para inundar un objetivo con tráfico excesivo, impidiendo su operación normal.

- Password Attack: Incluye métodos para descifrar o adivinar contraseñas, como brute force guessing y dictionary attacks.

- Drive-By Attack: Descarga malware en el dispositivo de un usuario simplemente visitando un sitio web comprometido, sin interacción activa del usuario.

- Ransomware Attack: Malware que cifra archivos del usuario, exigiendo un pago para su descifrado. Se propaga mediante phishing, exploits y drive-by downloads.

Para protegerse contra estos ataques, se recomienda emplear prácticas de seguridad como validación de entrada, cifrado de comunicaciones, educación en seguridad, actualizaciones regulares, copias de seguridad, y el uso de soluciones de seguridad avanzadas.

25 February 2024, 6:17 pm - Phishing: Ataque que engaña a los usuarios para obtener información confidencial, presentándose como una entidad confiable. Se subdivide en:

- 48 minutes 28 secondsSOC: Security Operations Center. Ciberseguridad a tiempo real

SOC (Security Operations Center)

Un SOC es una unidad especializada dentro de una organización dedicada a la monitorización, análisis, detección y respuesta ante amenazas cibernéticas. Opera 24/7 para proteger los activos digitales mediante la monitorización continua, el análisis de eventos, la detección de amenazas, la respuesta a incidentes y la gestión de la seguridad. El equipo de un SOC incluye analistas de seguridad, ingenieros, expertos en respuesta a incidentes y gestores, todos trabajando con herramientas avanzadas como IDS, IPS, firewalls, y plataformas de inteligencia de amenazas.

SIEM (Security Information and Event Management)

Un SIEM centraliza la recopilación, almacenamiento, análisis y correlación de eventos de seguridad de diversas fuentes, ofreciendo una visión holística y en tiempo real del estado de seguridad. Esto facilita la detección temprana de amenazas y una respuesta eficaz ante incidentes. Los componentes clave incluyen la recopilación de datos, normalización, almacenamiento, análisis, generación de alertas y una consola de usuario para la interacción.

WAF (Web Application Firewall)

Un WAF protege las aplicaciones web filtrando y bloqueando el tráfico malicioso para prevenir ataques como inyección de SQL y XSS. Puede ser basado en la nube, on-premise o híbrido, ofreciendo protección contra ataques comunes, mejorando la seguridad web y reduciendo el tiempo de respuesta a incidentes.

IDS (Intrusion Detection System)

Un IDS es una herramienta que monitoriza la red o sistemas informáticos en busca de actividades maliciosas o no autorizadas, generando alertas para una posible acción. Los IDS pueden ser basados en la red (NIDS), en el host (HIDS) o en aplicaciones (AIDS), y utilizan métodos de detección basados en firmas, anomalías y comportamientos.

IPS (Intrusion Prevention System)

Un IPS, al igual que un IDS, detecta actividades sospechosas pero también interviene activamente para prevenir daños, bloqueando tráfico malicioso o aislando dispositivos afectados. Los IPS pueden ser basados en la red (NIPS), en el host (HIPS) o en aplicaciones (AIPS), ofreciendo una capa adicional de seguridad.

SOAR (Security Orchestration, Automation, and Response)

Un SOAR mejora la eficiencia y eficacia de los equipos de seguridad mediante la orquestación y automatización de procesos y respuestas a incidentes. Integra diversas herramientas de seguridad y automatiza tareas rutinarias, proporcionando un marco de trabajo para respuestas rápidas y eficientes a las amenazas detectadas.

Diferencias entre IPS e IDS

Mientras que ambos sistemas detectan actividades maliciosas, el IPS se diferencia por su capacidad para prevenir intrusiones activamente, siendo más complejo y costoso que un IDS, que se enfoca en la detección y generación de alertas.

18 February 2024, 3:34 pm - 27 minutes 16 secondsIntroducción a OWASP

OWASP es una organización sin fines de lucro dedicada a mejorar la seguridad del software.

Ofrece recursos gratuitos como guías, herramientas y proyectos para ayudar a los desarrolladores y organizaciones a proteger sus aplicaciones web.

Algunos de sus recursos más conocidos son:- OWASP Top Ten: Lista de las 10 vulnerabilidades más críticas en aplicaciones web.

- OWASP ASVS: Marco de trabajo para la verificación de la seguridad de aplicaciones.

- OWASP ZAP: Herramienta para el análisis de vulnerabilidades en aplicaciones web.

OWASP también ofrece formación y eventos para la comunidad de seguridad.

La organización se actualiza constantemente para estar al día con las últimas amenazas y tecnologías.

OWASP es una comunidad global que trabaja por un futuro digital más seguro.

Puntos clave:

OWASP es un recurso invaluable para la seguridad de las aplicaciones web.

Es importante que los desarrolladores y organizaciones se familiaricen con los recursos de OWASP.

La participación en la comunidad de OWASP puede ayudar a mejorar la seguridad del software.Enlaces útiles:

Página principal de OWASP: https://owasp.org/

OWASP Top Ten: https://owasp.org/www-project-top-ten/

Recursos educativos y eventos: https://owasp.org/www-community/Conclusión:

OWASP es una organización líder en la seguridad de aplicaciones web. Sus recursos gratuitos son una herramienta esencial para cualquier persona que desarrolle o gestione aplicaciones web. La participación en la comunidad de OWASP puede ayudar a mejorar la seguridad del software para todos.

10 February 2024, 8:23 am - 1 hour 22 minutes«SAR o no SAR» con LinuxDoesMatter y ChatGPT

Prompt 1:

“Tengo en un servidor Linux un directorio que se llama /bk_datos. Quiero que de otro directorio de mi host llamado /datos_2024 se haga una copia de seguridad total los sábados a las 18:30pm y una copia incremental de Lunes a Viernes a las 22:00pm en el directorio /bk_datos Quiero que uses el comando tar y que comprimas con xz”.

Respuesta 1:

#!/bin/bash # Ruta del directorio de origen source_directory="/datos_2024" # Ruta del directorio de destino backup_directory="/bk_datos" # Nombre del archivo de copia de seguridad backup_file="$backup_directory/backup_$(date +\%Y-\%m-\%d_%H-\%M).tar.xz" # Verificar si es sábado if [ "$(date +\%u)" -eq 6 ]; then # Copia de seguridad total los sábados a las 18:30 tar --listed-incremental="$backup_directory/incremental.snar" -cJf "$backup_file" "$source_directory" echo "Copia de seguridad total realizada el $(date +\%Y-\%m-\%d_%H-\%M)." else # Copia de seguridad incremental de Lunes a Viernes a las 22:00 tar --listed-incremental="$backup_directory/incremental.snar" -cJf "$backup_file" "$source_directory" echo "Copia de seguridad incremental realizada el $(date +\%Y-\%m-\%d_%H-\%M)." fi ……………………………………… chmod +x backup_script.sh # Copia total los sábados a las 18:30 30 18 * * 6 /ruta/al/backup_script.sh # Copia incremental de lunes a viernes a las 22:00 0 22 * * 1-5 /ruta/al/backup_script.shReferencia: https://juncotic.com/tar-backups-incrementales-gnu-linux/

Solo me queda añadir la lógica para que el sábado “expulse” el snapshot y haga un backup total puro y duro creando el fichero de snapshot incremental .snar nuevecito para los subsiguientes incrementales de lunes a viernes.

Conclusión: ChatGPT Me ha ayudado mucho no, ¡muchísimo! pero hay veces que el remate lo tiene que hacer el “ser humano”.

Prompt 2:

“Tengo un partición montada en un directorio que se llama /proyecto_seal y tengo tres usuarios user01, user02 y user03. Quiero que los tres usuarios tengan acceso a este directorio. También quiero una política de cuotas con un soft limit de 2G y periodo de gracia de 3 dias y una hard limit de 5G. Otorga al directorio el permiso apropiado para que ningún usuario de esto tres pueda borrar lo que han creado los otros”

Respuesta 2:

# Asegúrate de que el grupo exista, si no, créalo sudo groupadd proyecto_seal # Añade usuarios al grupo sudo usermod -aG proyecto_seal user01 sudo usermod -aG proyecto_seal user02 sudo usermod -aG proyecto_seal user03 # Cambia el propietario y grupo del directorio sudo chown :proyecto_seal /proyecto_seal # Establece permisos para el propietario (dueño del directorio) sudo chmod 1770 /proyecto_seal # Permite que los miembros del grupo tengan acceso total sudo chmod g+rwx /proyecto_seal # Restringe el acceso a otros usuarios (no propietarios ni del grupo) sudo chmod o-rwx /proyecto_seal sudo apt-get install quota vi /etc/fstab UUID=xxxxxxxx-xxxx-xxxx-xxxx-xxxxxxxxxxxx /proyecto_seal ext4 defaults,usrquota,grpquota 0 2 sudo mount -o remount /proyecto_seal sudo quotacheck -cug /proyecto_seal sudo edquota -u user01 sudo edquota -u user02 sudo edquota -u user03Prompt 3:

Tengo un fichero de texto con paths completos de directorios, algunos caminos empiezan por /usr/bin/local/ y quiero en estos que empiezan por /usr/bin/local/ y solo en estos eliminar /usr/bin/local/ ¿Me creas un script para realizar esta tarea?

Respuesta 3:

#!/bin/bash # Verificar si se proporcionó un archivo como argumento if [ -z "$1" ]; then echo "Uso: $0 archivo" exit 1 fi archivo="$1" # Verificar si el archivo existe if [ ! -f "$archivo" ]; then echo "El archivo '$archivo' no existe." exit 1 fi # Crear un archivo temporal para almacenar los resultados archivo_temporal=$(mktemp) # Procesar el archivo línea por línea while IFS= read -r linea; do # Verificar si la línea comienza con /usr/bin/local/ if [[ "$linea" == "/usr/bin/local/"* ]]; then # Eliminar /usr/bin/local/ de la línea nueva_linea="${linea#/usr/bin/local/}" echo "$nueva_linea" >> "$archivo_temporal" else # Conservar la línea tal cual si no comienza con /usr/bin/local/ echo "$linea" >> "$archivo_temporal" fi done < "$archivo" # Sobrescribir el archivo original con los resultados mv "$archivo_temporal" "$archivo" echo "Proceso completado. Se ha modificado el archivo '$archivo'."Y vamos con SAR…

sar es una herramienta de monitorización de recursos en sistemas basados en Unix, como Linux. El nombre «sar» proviene de «System Activity Reporter». Esta utilidad permite recopilar, informar y analizar datos sobre la actividad del sistema, incluyendo el uso de CPU, memoria, E/S (entrada/salida) y otros recursos.

El paquete sar generalmente viene incluido en el conjunto de herramientas de sysstat. Para utilizar sar en Linux, debes asegurarte de que sysstat esté instalado.

Con mucha seguridad el paquete systat estará instalado pero si no procedemos como siempre

yum install sysstat -y systemctl start sysstat.service systemctl enable sysstat.service

Para Centos/Redhat sería algo como esto… yum o dnfPero ya que estamos con ChatGPT usamos este PROMPT para que nos diga cómo ponerlo en marcha. No obstante la instalación y puesta en marcha de sar/sysstat está francamente bien documentado en montones de sitios web que se encuentran con la oportuna búsqueda en google.

“¿Me explicas detalladamente cómo poner en marcha sar en Linux Centos a partir de la instalación de sysstat?”

Respuesta de ChatGPT:

Paso 1: Instalar sysstat sudo yum install sysstat Paso 2: Habilitar y configurar sysstat sudo nano /etc/sysconfig/sysstat Dentro de este archivo, asegúrate de que la variable ENABLED esté establecida en "true". Si no está configurada, cámbiala a: ENABLED="true" Paso 3: Iniciar y activar el servicio sysstat sudo systemctl start sysstat sudo systemctl enable sysstat Paso 4: Configurar la recopilación automática de datos La recopilación automática de datos se realiza mediante el cron. El archivo /etc/cron.d/sysstat configura la programación de las actividades de recopilación. Abre el archivo /etc/cron.d/sysstat en un editor de texto: sudo nano /etc/cron.d/sysstat Asegúrate de que la tarea cron esté descomentada y configurada según tus necesidades. Por defecto, la recopilación de datos se programa cada 10 minutos: */10 * * * * root /usr/lib64/sa/sa1 1 1 Puedes ajustar el intervalo según tus preferencias.Genial respuesta una vez puesto en marcha empezamos ejecutar comandos sar para indagar la carga del sistema en diferentes aspectos…

Esta utilidad permite recopilar, informar y analizar datos sobre la actividad del sistema, incluyendo el uso de CPU, memoria, E/S (entrada/salida), swap, disco, paginación, red, etc.

Vamos a crear prompts para que me genere informes sobre cada uno de estos aspectos.

“ChatGPT voy a arrancar un aplicación en Linux y quiero saber el impacto a nivel de consumo de CPU que va a tener. Créame el comando sar para esta prueba y poder observar el consumo de CPU por la ejecuc.ión de esta aplicación”

Respuesta de ChatGPT: Eso es en el presente.

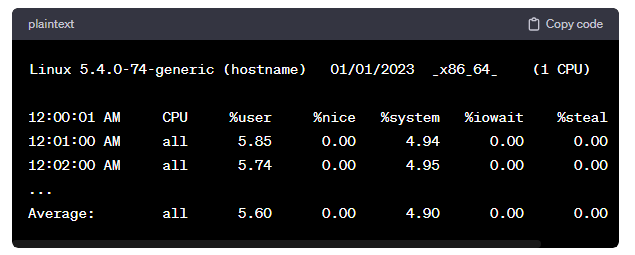

sar -u 1 Este comando recopilará estadísticas de CPU cada segundo (-u 1) y mostrará el uso de CPU, carga promedio y más. Ejecuta tu aplicación: Inicia la aplicación que deseas probar. Mientras se ejecuta, sar continuará recopilando y mostrando estadísticas de CPU cada segundo. Detén la recopilación de datos de sar: Puedes detener la recopilación de datos presionando Ctrl + C. Después de esto, sar mostrará un resumen del uso de la CPU durante el período de recopilación. El comando y la salida se verán algo así: Esto en el presente:

En esta salida, %user representa el porcentaje de tiempo de CPU gastado en el espacio de usuario (aplicaciones), y %system representa el porcentaje de tiempo de CPU gastado en el kernel del sistema.

Observa los valores de %user y %system para evaluar el impacto en el consumo de CPU de tu aplicación durante la ejecución. También puedes ajustar el intervalo de recopilación (1 en el comando -u 1) según tus necesidades para obtener más o menos granularidad en los datos recopilados.

ChatGPT dime cómo evolucionó el consumo de CPU entre las 01:00am y 4:00am del 12 de enero de 2024. Dame por favor el comando sar que debo ejecutar.

Salida de ChatGPT: Esto es una pregunta “hacia el pasado”.

Evolución ficticia Linux 5.4.0-74-generic (hostname) 12/01/2024 _x86_64_ (1 CPU) 01:00:00 AM CPU %user %nice %system %iowait %steal %idle 01:10:00 AM all 10.00 0.50 5.00 0.00 0.00 84.50 01:20:00 AM all 12.00 0.75 6.00 0.10 0.05 81.10 01:30:00 AM all 15.00 1.00 7.50 0.20 0.10 76.20 ... 03:50:00 AM all 25.00 2.00 12.50 0.50 0.25 60.75 04:00:00 AM all 22.50 1.75 11.25 0.30 0.15 64.05

Una vez visto cómo se construye el comando sar para ver el consumo de CPU a través del prompt de ChatGPT, os toca a vosotros extrapolarlo los siguientes aspectos del rendimiento del sistema

Listado de comandos básicos de sar para monitorear diferentes aspectos del sistema, con ejemplos sencillos: 1. Uso de CPU: Comando: sar -u 1 Ejemplo: sar -u 1 Descripción: Muestra estadísticas de uso de CPU cada segundo. 2. Uso de Memoria RAM: Comando: sar -r 1 Ejemplo: sar -r 1 Descripción: Muestra estadísticas de uso de memoria RAM cada segundo. 3. Uso de Swap: Comando: sar -S 1 Ejemplo: sar -S 1 Descripción: Muestra estadísticas de uso de swap cada segundo. 4. Uso de Disco: Comando: sar -b 1 Ejemplo: sar -b 1 Descripción: Muestra estadísticas de E/S de bloque (disco) cada segundo. 5. Paginación: Comando: sar -B 1 Ejemplo: sar -B 1 Descripción: Muestra estadísticas de paginación cada segundo. 6. Estadísticas de Red: Comando: sar -n DEV 1 nota DEV seria eth0, eth1, enp0s3, etc Ejemplo: sar -n DEV 1 Descripción: Muestra estadísticas de red para cada interfaz de red cada segundo. Estos comandos te proporcionarán información útil sobre el rendimiento del sistema en tiempo real. Puedes ajustar el intervalo (1 en los ejemplos) según tus necesidades. Recuerda que la disponibilidad de ciertas métricas puede variar según tu sistema operativo y configuración específica.Muy probablemente ya sar estará up & running en vuestro servidor. Yo personalmente tengo ya unos comandos sar preparados que los utilizo cuando hay una “crisis” las respuestas de ChartGPT complementan y refuerzan mi colección de comando sar para momentos en que el servidor esta impactado y quiero saber que pasó a nivel me memoria, cpu, swap, red, etc en el pasado.

Imagen generada con Bing:

Enlaces a las clases y los talleres:

Clase 1

https://growthhackingcourse.io/clases-chatgpt/

Clase 2

https://growthhackingcourse.io/clase-2-chatgpt-dominando-los-prompts/

Clase 3

https://growthhackingcourse.io/clase-3-chatgpt-automatizando-la-generacion-de-contenidos/

Taller1:

https://directo.growthhackingcourse.io/taller-chat-gpt-en-directo/

Taller2:

https://www.youtube.com/watch?v=-f2xdGwkO3k28 January 2024, 1:31 pm - 50 minutes 40 secondsSegment Routing

Definición y Orígenes del Segment Routing

- ¿Qué es el Segment Routing? El SR es una técnica de encaminamiento de red que simplifica la complejidad y mejora la eficiencia y escalabilidad de las redes. Utiliza una lista de instrucciones, o segmentos, para dirigir los paquetes a través de un camino específico en la red, reduciendo la necesidad de mantener estados y políticas complejas en cada nodo.

- Orígenes y Evolución: SR se desarrolló a partir de las redes de telecomunicaciones y es una evolución de protocolos tradicionales como OSPF y BGP, así como del MPLS. Empezó a emerger en la década de 2010, construido sobre MPLS pero con mayor énfasis en la simplificación y eficiencia.

Conceptos Básicos del Segment Routing

- Funcionamiento: SR utiliza ‘segmentos’ para definir el camino de un paquete, bajo el principio de «encaminamiento de origen». Esto permite un encaminamiento más directo y eficiente y una reducción de la complejidad.

- Diferencias con el Encaminamiento Tradicional: SR simplifica la gestión de la red al reducir la necesidad de estados y políticas en cada nodo.

- Componentes Clave: Los segmentos y los identificadores de segmento (SIDs) son fundamentales en SR. Puede implementarse como SR-MPLS o SRv6, dependiendo de si se usa sobre infraestructura MPLS existente o directamente sobre IPv6.

Funcionamiento Técnico del Segment Routing

- Arquitectura del SR: Se centra en la simplicidad y eficiencia, utilizando SIDs para guiar los paquetes. Hay SIDs de nodo y SIDs de enlace para controlar el tráfico.

- Integración en la Red: La integración de SR en redes existentes es factible, especialmente en aquellas que ya utilizan MPLS o IPv6.

- Proceso de Encaminamiento: Los paquetes son etiquetados con SIDs que representan su ruta, y cada nodo procesa estos SIDs para dirigir el paquete.

- Protocolos de Soporte: SR utiliza protocolos como IS-IS, OSPF y BGP para la distribución de información sobre SIDs y topología de la red.

Ventajas y Aplicaciones del Segment Routing

- Beneficios: Incluyen mayor eficiencia, escalabilidad, simplificación de la red, gestión de tráfico más flexible y mejor calidad de servicio.

- Casos de Uso: SR es útil en redes de operadores, centros de datos, aplicaciones en la nube, y redes móviles y 5G.

Segment Routing en la Práctica

- Implementación y Configuración: Incluye evaluación de la red, selección de infraestructura SR, actualización de firmware/software, configuración de SIDs y protocolos de encaminamiento, pruebas y monitoreo.

- Herramientas y Tecnologías Complementarias: Se recomienda el uso de dispositivos de red compatibles, software de gestión y la integración con SDN para una gestión más dinámica.

Desafíos y Consideraciones en el Segment Routing

- Retos en la Implementación: Comprenden complejidades técnicas, requisitos de hardware y seguridad.

- Consideraciones de Seguridad: Incluyen la protección de la topología de red y las políticas de seguridad.

El Futuro del Segment Routing

- Tendencias y Desarrollos Futuros: Avances en automatización, integración de IA, desarrollo de SRv6 y su integración con 5G y redes móviles.

- Impacto en la Evolución de las Redes: SR se prevé que aumente la eficiencia y flexibilidad de las redes y facilite la transición a SDN y el soporte de tecnologías emergentes.

Conclusión

- El SR es un cambio paradigmático en la tecnología de redes, ofreciendo soluciones eficientes, escalables y flexibles. Su importancia yace en su capacidad para manejar la creciente demanda de datos y servicios de red personalizados, siendo fundamental en la gestión de redes complejas y en la habilitación de tecnologías futuras como 5G y IoT.

Preguntas y respuestas

- ¿Qué es el Segment Routing (SR)?

- El Segment Routing es una técnica de encaminamiento de red que simplifica la complejidad, mejora la eficiencia y escalabilidad de las redes, utilizando una serie de instrucciones o segmentos para dirigir los paquetes.

- ¿Cómo se diferencia el Segment Routing de las prácticas de encaminamiento tradicionales?

- A diferencia del encaminamiento tradicional, el Segment Routing no requiere estados ni políticas complejas en cada nodo, y permite que el remitente del paquete defina su ruta exacta, reduciendo la sobrecarga en la red.

- ¿Cuál es la principal ventaja del Segment Routing sobre MPLS?

- Aunque se basa en la idea de MPLS, el Segment Routing ofrece una mayor simplificación y eficiencia, eliminando la necesidad de mantener un estado complejo en cada nodo de la red.

- ¿Qué son los Identificadores de Segmento (SIDs) en el contexto del Segment Routing?

- Los SIDs son etiquetas únicas asignadas a dispositivos o rutas en la red, que determinan la trayectoria de un paquete, actuando como instrucciones específicas para su encaminamiento.

- ¿Cómo se implementa el Segment Routing sobre diferentes infraestructuras?

- El SR puede implementarse como SR-MPLS sobre la infraestructura MPLS existente, o como SRv6 directamente sobre la infraestructura IP (IPv6), aprovechando las capacidades de IPv6 para la integración del encaminamiento.

- ¿Cuáles son algunas ventajas clave del Segment Routing?

- El SR mejora la eficiencia y escalabilidad de la red, simplifica su gestión, ofrece flexibilidad en la gestión del tráfico, y mejora la calidad del servicio.

- ¿Qué desafíos presenta la implementación del Segment Routing en las redes modernas?

- Los desafíos incluyen la complejidad técnica, la necesidad de una cuidadosa planificación y diseño de la red, requisitos de hardware específicos, y consideraciones de seguridad.

- ¿Cómo contribuye el Segment Routing a la sostenibilidad de la red?

- Al mejorar la eficiencia y reducir la complejidad, el SR ayuda a disminuir el consumo de energía y la huella de carbono en las operaciones de red.

- ¿En qué áreas se espera que el Segment Routing tenga un impacto significativo en el futuro?

- Se espera que tenga un impacto en la automatización de la red, la integración con la inteligencia artificial, la expansión en sectores como 5G y redes móviles, y en la transición a redes definidas por software (SDN).

- ¿Por qué se considera el Segment Routing un cambio paradigmático en la tecnología de redes?

- Porque aborda directamente las limitaciones de los métodos de encaminamiento tradicionales, adaptándose a las necesidades cambiantes de las redes modernas, y ofreciendo una solución que es eficiente, escalable y flexible. Su capacidad para integrarse con tecnologías emergentes lo posiciona como fundamental en la gestión de redes complejas y en el soporte de innovaciones futuras.

23 January 2024, 7:01 pm - 46 minutes 48 secondsInfiniBand

InfiniBand es una arquitectura de red de alto rendimiento utilizada principalmente en entornos de computación de alto rendimiento (HPC). Se destaca por su baja latencia y alto ancho de banda, ideal para el transporte rápido y eficiente de grandes volúmenes de datos. Sus características clave incluyen:

- Arquitectura Punto a Punto: Conmutadores conectan dispositivos como servidores y sistemas de almacenamiento, permitiendo comunicación directa y eficiente.

- Alto Ancho de Banda y Baja Latencia: Ofrece velocidades desde 2.5 Gbps hasta 800 Gbps en las versiones más recientes, adecuadas para aplicaciones intensivas en datos.

- Protocolo de Transporte Propio: Diferente a los protocolos de Ethernet o Fibre Channel, optimizado para transporte eficiente y confiable de datos.

- Virtualización de Canales: Permite múltiples enlaces lógicos sobre un enlace físico, aumentando la flexibilidad y eficiencia en la gestión del tráfico.

- Calidad de Servicio (QoS): Capacidades avanzadas para priorizar tráfico y garantizar rendimiento consistente.

- Soporte de RDMA: Permite acceso directo a la memoria de otros dispositivos sin intervención del procesador, reduciendo latencia.

- Uso en Clústeres y HPC: Popular en aplicaciones de procesamiento intensivo de datos como simulación científica y modelado financiero.

- Compatibilidad y Convergencia: Desarrollos en la convergencia con tecnologías Ethernet, permitiendo coexistencia en algunos entornos.

La arquitectura de InfiniBand se caracteriza por componentes como Host Channel Adapters (HCA) y Target Channel Adapters (TCA), conmutadores para enrutamiento y conmutación eficiente, y soporte para virtualización de canal y protocolo de transporte propio. Su escalabilidad, gestión avanzada de QoS, y soporte para múltiples tipos de conexión, como enlaces de cobre y fibra óptica, la hacen ideal para aplicaciones que requieren un transporte rápido y eficiente de grandes cantidades de datos.

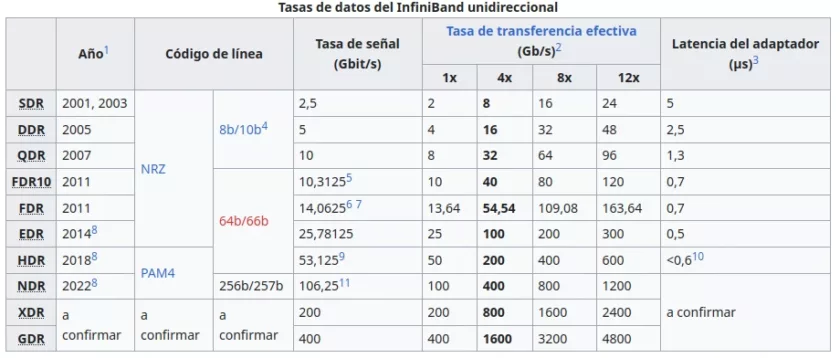

El ancho de banda y la latencia son aspectos cruciales de InfiniBand, con tasas de transferencia evolucionando de 2.5 Gbps (SDR) a 800 Gbps en las versiones futuras. La latencia extremadamente baja es fundamental para aplicaciones que requieren respuestas rápidas.

Tasas de datos del InfiniBand unidireccional, exxtraído de Wikipedia (https://es.wikipedia.org/wiki/InfiniBand)

Tasas de datos del InfiniBand unidireccional, exxtraído de Wikipedia (https://es.wikipedia.org/wiki/InfiniBand)

El protocolo de transporte de InfiniBand, orientado a mensajes y con soporte para RDMA, gestiona conexiones confiables y no confiables, y conexiones orientadas a datagramas. Incluye mecanismos sofisticados para la gestión de la congestión y QoS, y es escalable y de alto rendimiento.

La virtualización de canales mejora la flexibilidad y eficiencia de la red, permitiendo una mejor utilización del ancho de banda y una implementación eficiente de QoS. La Calidad de Servicio en InfiniBand gestiona el ancho de banda y prioriza el tráfico, crucial para mantener la eficiencia en redes de alto rendimiento.

El RDMA en InfiniBand permite accesos directos a la memoria de sistemas remotos, reduciendo la latencia y mejorando el rendimiento, especialmente útil en HPC y almacenamiento de datos.

InfiniBand es clave en clústeres y HPC por su bajo ancho de banda y latencia, soporte para RDMA, escalabilidad, y soporte para aplicaciones paralelas y de alto rendimiento. Su convergencia con Ethernet en centros de datos es una tendencia creciente, ofreciendo flexibilidad operativa y optimización de costos, aunque requiere gestión cuidadosa para garantizar rendimiento y priorización efectiva del tráfico.

2 January 2024, 4:16 pm - 25 minutes 23 secondsIGMP e IGMP Snooping

El Protocolo de Gestión de Grupos de Internet (IGMP) y su variante avanzada, IGMP Snooping, son componentes cruciales en la gestión del tráfico de multicast en redes IP modernas. A lo largo de nuestra discusión, hemos explorado las diferentes versiones de IGMP, sus aplicaciones, y cómo IGMP Snooping mejora la eficiencia en switches. También hemos abordado cómo configurar IGMP versión 3 en un switch Nexus de Cisco.

IGMP: Versiones y Evolución

IGMP Versión 1

- Primera implementación del protocolo IGMP.

- Funcionalidad básica para permitir que los hosts informen a los routers sobre su interés en grupos de multicast.

- Limitación principal: no permite a los hosts dejar un grupo de multicast de manera explícita.

IGMP Versión 2

- Introduce mejoras significativas sobre IGMPv1.

- Capacidad de «Dejar Grupo» para que los hosts indiquen que ya no desean recibir tráfico de un grupo específico.

- Introduce tiempos de respuesta variables, reduciendo la congestión de mensajes IGMP.

IGMP Versión 3

- Aporta soporte para multicast de Origen Específico (SSM).

- Permite a los hosts especificar no solo el grupo de multicast al que desean unirse, sino también seleccionar fuentes específicas de tráfico.

- Mejora significativamente la eficiencia y la seguridad del tráfico de multicast.

Aplicaciones de IGMP

IGMP es fundamental en aplicaciones que requieren la transmisión de datos a múltiples receptores de manera eficiente. Esto incluye:

- Streaming de video y audio, como IPTV.

- Juegos en línea y aplicaciones de realidad virtual.

- Teleconferencias y colaboración en línea.

IGMP Snooping

Concepto

- Técnica utilizada en switches para optimizar la gestión del tráfico de multicast.

- El switch «espía» los mensajes IGMP para aprender qué hosts están interesados en recibir tráfico de grupos específicos de multicast.

Funcionamiento

- El switch mantiene una tabla que asocia grupos de multicast con puertos específicos.

- Solo envía tráfico de multicast a los puertos que tienen hosts interesados, optimizando el uso del ancho de banda.

Aplicaciones

- Redes de IPTV y streaming de contenido.

- Redes corporativas para distribución de contenido y videoconferencias.

- Ambientes de juegos en línea.

Configuración de IGMPv3 en Switches Nexus de Cisco

Pasos Básicos

- Acceso a la Configuración del Dispositivo: Iniciar sesión en el switch y entrar en el modo de configuración.

- Habilitar IGMP Snooping: Importante para optimizar la gestión del tráfico de multicast.

- Configurar las Interfaces: Seleccionar y configurar la interfaz específica o VLAN donde se habilitará IGMPv3.

- Habilitar IGMPv3 en la Interfaz: Activar IGMP versión 3 en la interfaz seleccionada.

- Ajustes Adicionales: Configurar tiempos de consulta, suscripción y otros parámetros según necesidades de la red.

- Guardar la Configuración: Asegurar que los cambios se mantengan después de reiniciar el dispositivo.

En conclusión, IGMP y IGMP Snooping son tecnologías esenciales en la administración de redes modernas, proporcionando herramientas fundamentales para la gestión eficiente del tráfico de multicast. Sus aplicaciones van desde el streaming de medios hasta la colaboración en entornos corporativos y educativos, subrayando su importancia en la infraestructura de red

Foto de Fernando González

26 December 2023, 5:53 pm - 56 minutes 40 secondsControl de Congestión en TCP

El otro día @eva_cb , una profesora de la URJC, hizó un tweet en el que incluía una serie de comandos que se utilizan en un entorno Linux para configurar y modificar el comportamiento del protocolo de control de transmisión (TCP).

To get a capture file of the basic behavior of TCP

sysctl -w net.ipv4.tcp_sack=0

sysctl -w net.ipv4.tcp_timestamps=0

sysctl -w net.ipv4.tcp_window_scaling=0

echo "4096 8192 8192" > /proc/sys/net/ipv4/tcp_rmem

ifconfig eth0 mtu 1040

tc qdisc add dev eth0 root netem loss 25% pic.twitter.com/rADFzuD1Qw— eva (@eva_cb) December 1, 2023

La verdad es que el tweet me gustó mucho y me hizo pensar que no había hablado de control de congestión en el podcast todavía, así que le he robado vilmente la idea y hoy voy a hablar en el podcast un poco de control de control de congestión en TCP.

La verdad es que me tocó repasar porque, voy a ser sincero, no lo tenía nada fresco esto, hace mucho tiempo, hace unos 11 ó 12 porque en Tecnocrática tenemos los servidores web con un pequeño tuning para mejorar el rendimiento, pero eso es cosa para otro día.

Fundamentos del Control de Congestión de TCP

Definición y Objetivos del Control de Congestión

El control de congestión en TCP (Protocolo de Control de Transmisión) es un mecanismo diseñado para regular la cantidad de datos que pueden ser enviados a la red sin confirmación. Su principal objetivo es evitar la sobrecarga de la red, que puede ocurrir cuando demasiados paquetes son enviados en un período corto, superando la capacidad de la red para manejarlos eficientemente. Esta regulación es crucial para mantener un rendimiento óptimo y la estabilidad de la red.

La congestión se produce cuando los nodos de la red (como routers y switches) están sobrecargados de datos, lo que lleva a un aumento en el tiempo de retardo y la probabilidad de pérdida de paquetes. El control de congestión busca equilibrar la carga en la red, ajustando dinámicamente la tasa de transmisión de los datos en función de las condiciones actuales de la red. Esto se logra mediante una serie de algoritmos y mecanismos que detectan, previenen y reaccionan ante los signos de congestión.

Problemas Causados por la Congestión de Red

La congestión en una red de datos puede llevar a varios problemas serios, entre ellos:

- Pérdida de Paquetes: Cuando los buffers en los routers se llenan debido a la congestión, los paquetes en exceso son descartados, lo que requiere su retransmisión y, por ende, reduce la eficiencia general de la red.

- Latencia Alta: Un mayor volumen de tráfico en la red puede aumentar significativamente los tiempos de retardo, afectando negativamente la experiencia del usuario, especialmente en aplicaciones en tiempo real como las llamadas VoIP y juegos en línea.

- Fluctuaciones de Throughput: La variabilidad en el throughput (rendimiento) de la red puede ser un signo de congestión intermitente, lo que dificulta la planificación de la capacidad y la calidad del servicio.

- Injusticia en la Asignación de Recursos: Sin un control de congestión efectivo, ciertos flujos de datos pueden monopolizar los recursos de la red, mientras que otros pueden quedar con un ancho de banda insuficiente.

Diferencia entre Control de Congestión y Control de Flujo

Aunque a menudo se confunden, el control de congestión y el control de flujo en TCP son mecanismos distintos diseñados para resolver diferentes problemas:

- Control de Flujo: Se enfoca en la relación entre el emisor y el receptor. Su objetivo es evitar que el emisor sobrecargue al receptor con demasiados datos. Utiliza el mecanismo de ventana deslizante de TCP, donde el receptor anuncia dinámicamente el tamaño de la ventana de recepción (la cantidad de datos que está dispuesto a recibir antes de enviar un acuse de recibo) al emisor, regulando así la velocidad a la que el emisor puede enviar datos.

- Control de Congestión: Por otro lado, el control de congestión se ocupa de la relación entre el emisor y la red. Busca prevenir o mitigar la sobrecarga de datos en la red para mantener un alto rendimiento y evitar la pérdida de paquetes. A diferencia del control de flujo, que es una cuestión de capacidad del receptor, el control de congestión se relaciona con la capacidad de toda la red.

En resumen, mientras que el control de flujo se asegura de que el receptor no se vea abrumado, el control de congestión se asegura de que la red en su conjunto no se vea sobrecargada. Ambos mecanismos trabajan en conjunto para garantizar una transmisión de datos eficiente y fiable en TCP.

Mecanismos Básicos de Control de Congestión en TCP

El control de congestión en TCP emplea varios mecanismos fundamentales para gestionar y mitigar la congestión en las redes. Estos mecanismos trabajan juntos para ajustar la tasa de envío de datos, basándose en la percepción del estado actual de la red. Los más importantes son el Slow Start, Congestion Avoidance, Fast Retransmit y Fast Recovery.

Slow Start (Inicio Lento)

- Funcionamiento: El algoritmo de Slow Start es el primer paso en el control de congestión de TCP. Al iniciar una conexión, TCP no sabe cuánta capacidad está disponible en la red. Por lo tanto, comienza con una tasa de envío conservadora. Inicia con una ventana de congestión pequeña, típicamente de uno o dos segmentos de tamaño máximo de segmento (MSS). Por cada acuse de recibo (ACK) recibido, el tamaño de la ventana de congestión se incrementa en un MSS, lo que lleva a un aumento exponencial del tamaño de la ventana por cada RTT (Round-Trip Time).

- Objetivo: El objetivo es aumentar rápidamente la tasa de transmisión hasta encontrar la capacidad de la red, sin iniciar la transferencia con una carga pesada que podría provocar inmediatamente congestión.

Congestion Avoidance (Evitación de la Congestión)

- Funcionamiento: Una vez que la ventana de congestión alcanza un umbral específico (el umbral de congestión), el algoritmo de Congestion Avoidance toma el control. A partir de este punto, el aumento del tamaño de la ventana de congestión es más conservador. En lugar de duplicar la ventana cada RTT, se incrementa en un MSS por cada RTT, resultando en un crecimiento lineal. Este crecimiento más lento ayuda a evitar la saturación de la red.

- Objetivo: El principal objetivo es mantener el flujo de datos en un nivel sostenible para evitar la congestión, aumentando gradualmente el tamaño de la ventana de congestión mientras se monitoriza el rendimiento de la red.

Fast Retransmit (Retransmisión Rápida)

- Funcionamiento: Fast Retransmit es un mecanismo que mejora la eficiencia de la red al reducir el tiempo necesario para recuperarse de la pérdida de paquetes. Cuando un emisor recibe tres acuses de recibo duplicados (tres ACKs para el mismo segmento de datos), asume que un segmento se ha perdido y lo retransmite inmediatamente sin esperar a que expire el temporizador de retransmisión.

- Objetivo: Este mecanismo está diseñado para responder rápidamente a la pérdida de paquetes, una señal común de congestión en la red, minimizando así el impacto negativo en el rendimiento.

Fast Recovery (Recuperación Rápida)

- Funcionamiento: Fast Recovery trabaja en conjunto con Fast Retransmit. Una vez que se retransmite el paquete perdido, en lugar de reducir drásticamente la ventana de congestión y comenzar desde Slow Start, TCP entra en un estado de recuperación rápida. En este estado, la ventana de congestión se reduce a la mitad del tamaño que tenía cuando se detectó la pérdida. Luego, por cada ACK duplicado recibido, el tamaño de la ventana de congestión se incrementa en un MSS, hasta que todos los datos pendientes son reconocidos.

- Objetivo: El objetivo de Fast Recovery es reanudar rápidamente una tasa de transferencia efectiva después de una pérdida de paquetes, evitando el proceso más lento de Slow Start y aprovechando la información obtenida de los ACKs duplicados para ajustar el tamaño de la ventana.

En resumen, estos cuatro mecanismos son fundamentales para el eficiente control de congestión en TCP. El Slow Start permite a TCP iniciar la transmisión de datos de manera conservadora, aumentando exponencialmente el tamaño de la ventana hasta encontrar un límite sostenible. La Evitación de Congestión mantiene el crecimiento de la ventana en un ritmo lineal para evitar la saturación de la red. Fast Retransmit y Fast Recovery trabajan juntos para responder rápidamente a la pérdida de paquetes, permitiendo a TCP recuperar su tasa de transmisión de manera eficiente y minimizar la interrupción en la transferencia de datos.

Algoritmos Avanzados de Control de Congestión

Los algoritmos avanzados de control de congestión en TCP representan una evolución en la forma en que TCP gestiona la congestión y la pérdida de paquetes. Estos algoritmos incluyen Tahoe, Reno, NewReno, CUBIC y BBR, cada uno con características únicas adaptadas a diferentes escenarios de red.

Tahoe, Reno, y NewReno: Evolución y Diferencias en la Respuesta a la Pérdida de Paquetes

- Tahoe: Este fue uno de los primeros algoritmos en implementar los mecanismos de Fast Retransmit y Fast Recovery. En Tahoe, cuando se detecta una pérdida de paquetes (a través de tres ACKs duplicados o un timeout), la ventana de congestión se reduce a 1 MSS, y el algoritmo entra en Slow Start. Aunque eficaz en su época, Tahoe puede ser demasiado conservador, ya que reinicia el proceso de Slow Start tras cada pérdida detectada.

- Reno: Representa una mejora sobre Tahoe. Al igual que Tahoe, utiliza Fast Retransmit, pero difiere en su manejo de Fast Recovery. En Reno, cuando se detecta una pérdida de paquetes por ACKs duplicados, la ventana de congestión se reduce a la mitad, y no se reinicia completamente como en Tahoe. Esto permite una recuperación más rápida, ya que el algoritmo entra en Congestion Avoidance en lugar de Slow Start.

- NewReno: Mejora aún más el proceso de Fast Recovery. A diferencia de Reno, que solo puede recuperarse de una única pérdida de paquetes durante Fast Recovery, NewReno puede manejar múltiples pérdidas de paquetes. Si se detectan más pérdidas después de entrar en Fast Recovery, NewReno puede retransmitir los paquetes perdidos sin necesidad de salir de este modo, lo que mejora la eficiencia en situaciones con múltiples pérdidas de paquetes.

CUBIC: Algoritmo Utilizado por Linux, Adaptación en Función de la Latencia de la Red

CUBIC:Es el algoritmo de control de congestión predeterminado en muchas variantes de Linux.

CUBIC es diferente de los algoritmos basados en AIMD (Additive Increase/Multiplicative Decrease) como Tahoe, Reno y NewReno. Utiliza una función cúbica para aumentar la ventana de congestión, lo que permite un escalado más rápido de la ventana en redes con grandes capacidades de ancho de banda y alta latencia (redes de larga distancia). CUBIC es menos sensible a la pérdida de paquetes y más a los cambios en el retardo, lo que lo hace adecuado para redes modernas de alta capacidad.

BBR (Bottleneck Bandwidth and Round-trip Propagation Time): Enfoque en el Ancho de Banda y el Tiempo de Ida y Vuelta

BBR (Bottleneck Bandwidth and RTT): Desarrollado por Google, BBR es un algoritmo de control de congestión que se centra en maximizar la utilización del ancho de banda disponible y minimizar la latencia. BBR no se basa en la detección de pérdidas para ajustar la ventana de congestión. En su lugar, estima el ancho de banda del cuello de botella y el RTT mínimo para determinar el ritmo óptimo de envío de paquetes. Este enfoque permite que BBR gestione eficazmente la congestión, incluso en redes con altas tasas de pérdida de paquetes, ofreciendo mejoras significativas en el rendimiento en comparación con los algoritmos basados en pérdidas.

En resumen, estos algoritmos avanzados de control de congestión representan diferentes enfoques y estrategias para optimizar el rendimiento de la transmisión de datos en TCP. Tahoe, Reno, y NewReno se centran en mejorar la respuesta a la pérdida de paquetes, mientras que CUBIC y BBR se adaptan mejor a las redes modernas de alta capacidad, ofreciendo soluciones más eficientes para el control de la congestión en diversos entornos de red.

Impacto del Control de Congestión en Diferentes Tipos de Red

El control de congestión en TCP desempeña un papel vital en la gestión del tráfico de datos en diferentes tipos de redes. La eficacia y necesidad de los mecanismos de control de congestión pueden variar significativamente dependiendo de las características específicas de cada red, como la latencia, el ancho de banda disponible, y la probabilidad de pérdida de paquetes. Esto es particularmente evidente al comparar Redes de Área Local (LAN) con Redes de Área Amplia (WAN) y Redes Móviles.

Redes LAN vs. WAN: Cómo Varía el Control de Congestión

- Redes LAN:

- Características: Las LAN generalmente tienen baja latencia y alta capacidad de ancho de banda. La congestión es menos frecuente en las LAN debido a su corta distancia y a su infraestructura de red, que a menudo es de alta calidad y bien mantenida.

- Impacto del Control de Congestión: En las LAN, los algoritmos de control de congestión de TCP pueden no ser tan críticos o necesarios como en otros entornos. La baja latencia y el alto ancho de banda hacen que la red sea menos susceptible a la congestión, por lo que los mecanismos como Slow Start y Congestion Avoidance pueden no tener un impacto significativo en el rendimiento general.

- Redes WAN:

- Características: Las WAN, en contraste, se caracterizan por tener mayor latencia y un ancho de banda más variable. Estas redes abarcan distancias más largas y pueden incluir enlaces con capacidades de ancho de banda muy diferentes.

- Impacto del Control de Congestión: En las WAN, los algoritmos de control de congestión son fundamentales para mantener la estabilidad y eficiencia de la red. La variabilidad en la latencia y el ancho de banda hace que sea esencial un ajuste cuidadoso de la tasa de envío de datos para evitar la sobrecarga de los enlaces. Los mecanismos de control de congestión de TCP, como Fast Retransmit y Fast Recovery, son clave para responder rápidamente a la congestión y mantener un flujo de datos constante.

Redes Móviles: Desafíos Únicos y Adaptaciones en TCP

- Desafíos en Redes Móviles:

- Variabilidad en la Conexión: Las redes móviles enfrentan desafíos únicos debido a su naturaleza inalámbrica, como variabilidad en la calidad de la señal, cambios frecuentes en las condiciones de la red y tasas de error más altas.

- Cambios de Red y Movilidad: Los usuarios en redes móviles pueden cambiar entre diferentes tipos de redes (como pasar de 4G a Wi-Fi), lo que puede resultar en fluctuaciones significativas en el rendimiento y la disponibilidad de la red.

- Latencia y Pérdida de Paquetes: La latencia puede variar significativamente, y la pérdida de paquetes es más común, lo que puede ser malinterpretado por los algoritmos de control de congestión como señales de congestión de red.

- Adaptaciones en TCP para Redes Móviles:

- Algoritmos de Control de Congestión Adaptativos: Para abordar estos desafíos, se han desarrollado variantes de TCP específicas para entornos móviles, como TCP Vegas, que utiliza medidas de retardo para detectar y controlar la congestión, y TCP Westwood, que ajusta el tamaño de la ventana de congestión basándose en la estimación del ancho de banda disponible.

- Mejoras en la Detección de Congestión: Estas variantes mejoran la forma en que TCP interpreta la pérdida de paquetes y los cambios en la latencia, diferenciando mejor entre la congestión real y las características inherentes de las redes móviles.

- Optimizaciones para Movilidad: Además, se han realizado esfuerzos para mejorar la capacidad de TCP para manejar cambios en la conectividad y movilidad, como en MPTCP (Multipath TCP), que permite a TCP usar múltiples rutas para enviar y recibir datos, aumentando la robustez y eficiencia en entornos móviles.

En conclusión, el control de congestión en TCP varía considerablemente

Herramientas y Técnicas para la Gestión del Control de Congestión en TCP

La gestión eficaz del control de congestión en TCP es crucial para asegurar un rendimiento óptimo de la red. Esto incluye tanto el monitoreo continuo de la red para detectar signos de congestión como la configuración adecuada de los parámetros de control de congestión en los sistemas operativos. A continuación, se detallan algunas herramientas y técnicas clave en estas áreas.

Software y Herramientas para Monitorizar la Congestión de la Red

- Wireshark: Esta es una herramienta de análisis de protocolos de red que permite a los administradores capturar y examinar paquetes de datos en tiempo real. Puede ser utilizada para identificar patrones de congestión, como retransmisiones frecuentes y cambios en el tamaño de la ventana de congestión.

- NetFlow y sFlow: Estas tecnologías proporcionan información valiosa sobre los patrones de tráfico de la red, lo que ayuda a identificar la congestión. Herramientas basadas en NetFlow y sFlow pueden mostrar estadísticas detalladas sobre el tráfico y el volumen por interfaz, lo que es útil para detectar cuellos de botella.

- LibreNMS, Nagios o Zabbix: Estos sistemas de monitorización de red ofrecen capacidades para rastrear la salud de la red y pueden ser configurados para alertar sobre condiciones que pueden indicar congestión, como el uso excesivo del ancho de banda o altos tiempos de respuesta.

- Iperf/Jperf: Estas herramientas son utilizadas para medir el ancho de banda máximo de la red y pueden ayudar a determinar el impacto del control de congestión en el rendimiento de la red.

Configuración del Control de Congestión en Diferentes Sistemas Operativos

- Windows:

- Configuración del Registro: En Windows, algunos parámetros de TCP, incluyendo aquellos relacionados con el control de congestión, pueden ser ajustados a través del Editor del Registro. Esto permite a los administradores optimizar el rendimiento del TCP según las necesidades específicas de su red.

- PowerShell: Otra herramienta para ajustar la configuración de TCP en Windows es PowerShell, que ofrece comandos para modificar ajustes relacionados con el control de congestión.

- Linux:

- sysctl: Linux proporciona una interfaz sysctl para ajustar los parámetros del kernel en tiempo de ejecución. Los administradores pueden usar esta interfaz para cambiar los algoritmos de control de congestión y ajustar parámetros como el tamaño de la ventana de congestión y el comportamiento de retransmisión.

- /proc Interface: Algunas configuraciones de TCP también pueden ser ajustadas mediante la interfaz /proc, que permite a los usuarios modificar en tiempo real las configuraciones del kernel relacionadas con la red.

- macOS:

- Configuración del Sistema: Similar a Linux y Windows, macOS permite a los usuarios ajustar la configuración de TCP, aunque las opciones pueden ser más limitadas. La configuración se puede realizar a través de la línea de comandos o herramientas de terceros.

En resumen, una combinación de herramientas de monitoreo y técnicas de configuración adecuadas es esencial para una gestión efectiva del control de congestión en TCP. Estas herramientas y técnicas permiten a los administradores de red identificar y responder a la congestión, optimizando así el rendimiento de la red y asegurando una entrega de datos eficiente y fiable.

Casos de Estudio y Aplicaciones Prácticas

El control de congestión de TCP es un aspecto fundamental de la gestión de redes, vital para asegurar la estabilidad y eficiencia de las comunicaciones de datos. A continuación, exploraremos casos de estudio donde este control ha sido crucial y ejemplos prácticos de cómo la implementación y ajuste de TCP puede mejorar significativamente el rendimiento de la red.

Análisis de Casos donde el Control de Congestión de TCP ha sido Crucial

- Congestión en Redes de Datos Corporativas:

- Contexto: Las redes corporativas suelen experimentar un alto volumen de tráfico de datos, especialmente durante las horas pico.

- Problema: Sin un control de congestión eficaz, estas redes pueden experimentar una degradación significativa del rendimiento, con largos tiempos de respuesta y pérdida de paquetes.

- Solución: La implementación de algoritmos de control de congestión avanzados, como CUBIC o BBR, puede ayudar a gestionar la carga de tráfico de manera más eficiente, reduciendo la congestión y mejorando la experiencia del usuario final.

- Gestión de Tráfico en Proveedores de Servicios de Internet (ISP):

- Contexto: Los ISP manejan una gran cantidad de datos que atraviesan una variedad de redes.

- Problema: El control de congestión inadecuado puede llevar a cuellos de botella, afectando a múltiples clientes y servicios.

- Solución: La implementación de estrategias de control de congestión adaptativas, junto con un monitoreo constante del tráfico, permite a los ISP ajustar dinámicamente los parámetros de red para mantener un rendimiento óptimo.

- Streaming de Video y Servicios OTT:

- Contexto: Los servicios de streaming de video, como Netflix, dependen de una transferencia de datos constante y eficiente.

- Problema: La variabilidad en la calidad de la red puede provocar bufferings o interrupciones en el streaming.

- Solución: Al utilizar técnicas de control de congestión de TCP, estos servicios pueden adaptar la tasa de transmisión de datos según las condiciones de la red, minimizando las interrupciones y mejorando la calidad de transmisión.

Ejemplos Prácticos en la Implementación de Ajustes de TCP para Mejorar el Rendimiento

- Optimización de Redes de Centros de Datos:

- Aplicación: En centros de datos, donde los servidores manejan solicitudes masivas, el ajuste de TCP puede incluir la ampliación de la ventana de congestión y la implementación de algoritmos de control de congestión personalizados para manejar grandes volúmenes de datos.

- Beneficio: Esto resulta en un uso más eficiente de la capacidad de red disponible y una reducción en la latencia de las aplicaciones.

- Mejora del Rendimiento en Redes con Alta Latencia:

- Aplicación: En redes con alta latencia, como las conexiones satelitales, ajustar los parámetros de TCP para tener en cuenta la mayor RTT (tiempo de ida y vuelta) puede mejorar significativamente el rendimiento.

- Beneficio: La optimización de TCP en estos entornos puede reducir el impacto de la latencia y mejorar la eficiencia de la transmisión de datos.

- Configuración de TCP en Entornos Móviles:

- Aplicación: En redes móviles, donde la calidad de la conexión puede cambiar rápidamente, se pueden implementar variantes de TCP adaptativas como TCP Vegas o Westwood.

- Beneficio: Estas variantes están diseñadas para responder mejor a las fluctuaciones en la calidad de la conexión, mejorando la estabilidad y el rendimiento de las aplicaciones móviles.

En resumen, los casos de estudio y aplicaciones prácticas demuestran la importancia crítica del control de congestión de TCP en una variedad de entornos de red. Desde redes corporativas hasta proveedores de servicios de Internet y servicios de streaming, una gestión efectiva de la congestión de TCP es clave para mantener un rendimiento de red óptimo y proporcionar una experiencia de usuario final satisfactoria. La implementación de ajustes y algoritmos adecuados de TCP según las necesidades específicas.

Desafíos y Futuro del Control de Congestión de TCP

El control de congestión en TCP ha sido un área de investigación y desarrollo constante desde la creación del protocolo. Aunque los mecanismos actuales han demostrado ser eficaces en una amplia gama de escenarios de red, todavía enfrentan limitaciones significativas, especialmente en entornos de red en evolución. El futuro del control de congestión en TCP implica superar estos desafíos y adaptarse a las cambiantes demandas de las redes modernas.

Limitaciones Actuales del Control de Congestión en TCP

- Ineficiencia en Redes de Alta Velocidad y de Larga Distancia: Los algoritmos de control de congestión tradicionales pueden no ser eficientes en redes con grandes capacidades de ancho de banda y alta latencia (como enlaces transcontinentales), a menudo resultando en un uso subóptimo del ancho de banda disponible.

- Respuesta a la Pérdida de Paquetes vs. Calidad del Enlace: TCP generalmente interpreta la pérdida de paquetes como un signo de congestión. Sin embargo, en redes inalámbricas y móviles, la pérdida de paquetes a menudo se debe a problemas de calidad del enlace, no a la congestión, lo que lleva a una disminución innecesaria del rendimiento.

- Variabilidad en Redes Móviles y Inalámbricas: Las redes móviles presentan desafíos adicionales debido a su naturaleza inestable y variabilidad en la calidad de la conexión, lo que dificulta la efectividad de los mecanismos de control de congestión tradicionales.

- Interacción con Otros Protocolos y Tecnologías: A medida que nuevas tecnologías y protocolos emergen, la interacción entre estos y el control de congestión de TCP puede ser compleja y a menudo impredecible, afectando la eficiencia general del control de congestión.

Investigaciones y Desarrollos Futuros en la Gestión de la Congestión

- Algoritmos de Control de Congestión Inteligentes: El desarrollo de algoritmos de control de congestión basados en aprendizaje automático e inteligencia artificial promete una mayor eficiencia. Estos algoritmos podrían adaptarse dinámicamente a las condiciones cambiantes de la red, mejorando el rendimiento en diversos escenarios de red.

- Optimización para Redes Inalámbricas y Móviles: La investigación se está centrando en mejorar el control de congestión en entornos móviles y inalámbricos, con algoritmos que pueden diferenciar mejor entre la pérdida de paquetes debido a la congestión y la pérdida de paquetes debido a problemas de señal.

- Integración con Tecnologías Emergentes: A medida que nuevas tecnologías como 5G y IoT se vuelven más prevalentes, se necesitan métodos de control de congestión que puedan operar eficientemente en estos entornos altamente dinámicos y heterogéneos.

- Multipath TCP (MPTCP): MPTCP, que permite que las conexiones TCP utilicen múltiples rutas para enviar y recibir datos, se está explorando como una forma de mejorar la robustez y eficiencia de TCP. Esto es particularmente relevante en dispositivos móviles y en redes con múltiples interfaces de red.

- Control de Congestión Basado en la Retroalimentación de la Red: Explorar métodos donde la red misma proporciona retroalimentación al emisor sobre el estado de congestión, permitiendo ajustes más precisos y oportunos en el tamaño de la ventana de congestión.

- Estándares y Protocolos Más Flexibles: La evolución de TCP hacia un protocolo más modular y adaptable, donde los algoritmos de control de congestión pueden ser más fácilmente actualizados y optimizados para diferentes escenarios de red.

En resumen, los desafíos actuales del control de congestión en TCP están impulsando una investigación significativa y el desarrollo de nuevas tecnologías y enfoques. El futuro del control de congestión en TCP se orienta hacia una mayor inteligencia, adaptabilidad y eficiencia, con el objetivo de satisfacer las necesidades de las redes cada vez más rápidas, complejas y diversas de hoy en día.

Control de congestión en linux con sysctl

Volviendo al ejemplo de Eva:

sysctl -w net.ipv4.tcp_sack=0

sysctl -w net.ipv4.tcp_timestamps=0

sysctl -w net.ipv4.tcp_window_scaling=0

echo «4096 8192 8192» > /proc/sys/net/ipv4/tcp_rmem

ifconfig eth0 mtu 1040

tc qdisc add dev eth0 root netem loss 25%La secuencia de comandos que Eva nos muestra incluye una serie de comandos en Linux que ajustan varios parámetros del kernel relacionados con el protocolo TCP (Protocolo de Control de Transmisión) y la configuración de la interfaz de red. Estos comandos afectan cómo se maneja el tráfico de red en el sistema. Aquí está una explicación detallada de cada comando:

- sysctl -w net.ipv4.tcp_sack=0

- sysctl es una herramienta utilizada para modificar parámetros del kernel en tiempo de ejecución.

- net.ipv4.tcp_sack se refiere a la opción de Acuse de Recibo Selectivo (Selective Acknowledgment – SACK) en TCP. Esta opción permite al receptor informar al emisor exactamente qué segmentos se han recibido con éxito, lo que permite retransmitir eficientemente solo los segmentos perdidos.

- Al establecer tcp_sack en 0, se deshabilita esta característica. Esto puede ser útil en ciertos escenarios de red donde SACK puede no ser soportado o puede causar problemas, aunque generalmente es mejor mantenerlo habilitado para mejorar la eficiencia en la recuperación de errores.

- sysctl -w net.ipv4.tcp_timestamps=0

- net.ipv4.tcp_timestamps es una opción que controla el uso de marcas de tiempo en los paquetes TCP. Las marcas de tiempo pueden ser utilizadas para calcular el tiempo de ida y vuelta de los paquetes y ayudar a proteger contra envoltorios de números de secuencia en conexiones de larga duración.

- Al configurar tcp_timestamps en 0, se desactivan las marcas de tiempo en TCP. Esto podría ser útil en situaciones donde se sospecha que las marcas de tiempo están causando incompatibilidades o problemas de rendimiento, aunque generalmente es preferible mantenerlas activadas para una mejor estimación del RTT (Round-Trip Time) y seguridad.

- sysctl -w net.ipv4.tcp_window_scaling=0

- net.ipv4.tcp_window_scaling es una opción para habilitar el escalado de la ventana TCP. Esta característica permite el uso de ventanas de recepción más grandes, lo que es crucial para un alto rendimiento en conexiones de alta velocidad o con alta latencia.

- Al establecer tcp_window_scaling en 0, se desactiva el escalado de la ventana. Esto limita el tamaño máximo de la ventana de recepción a 65,535 bytes, lo que puede reducir significativamente el rendimiento en ciertos tipos de redes.

- echo "4096 8192 8192" > /proc/sys/net/ipv4/tcp_rmem

- Este comando ajusta la cantidad de memoria que TCP utiliza para el buffer de recepción. Los valores representan el mínimo, el valor por defecto, y el máximo tamaño del buffer, respectivamente, en bytes.

- Establecer estos valores puede ser útil para optimizar el uso de la memoria en función de las necesidades específicas de la red y del sistema. En este caso, se está configurando el tamaño predeterminado y máximo a 8192 bytes.

- ifconfig eth0 mtu 1040

- Este comando ajusta la MTU (Unidad Máxima de Transmisión) de la interfaz de red eth0 a 1040 bytes.

- La MTU es el tamaño máximo de un paquete que puede ser transmitido a través de una interfaz. Reducir la MTU puede ser útil en redes con problemas de paquetes grandes o para reducir la fragmentación en redes con una MTU más pequeña.

- tc qdisc add dev eth0 root netem loss 25%

- tc (Traffic Control) es una herramienta utilizada para controlar la política de transmisión de paquetes en Linux.

- Este comando específicamente añade una disciplina de cola (qdisc) a la interfaz eth0 para simular un 25% de pérdida de paquetes. Esto se hace a menudo con fines de pruebas o simulaciones para entender cómo las aplicaciones y los protocolos responden a tales condiciones de red.

Cada uno de estos comandos tiene aplicaciones específicas y debe ser utilizado con cuidado, ya que pueden tener un impacto significativo en el rendimiento y la fiabilidad de la red. Estos ajustes son a menudo específicos del escenario y deben ser probados y validados en un entorno controlado antes de ser implementados en un entorno de producción.

Preguntas y respuestas

- ¿Qué es el control de congestión en TCP?

- Es un mecanismo para regular la cantidad de datos enviados a la red sin confirmación, para evitar la sobrecarga de la red.

- ¿Cuál es el principal objetivo del control de congestión en TCP?

- Evitar la sobrecarga de la red, que puede ocurrir cuando se envían demasiados paquetes en un corto período.

- ¿Qué provoca la congestión en las redes?

- La sobrecarga de datos en los nodos de la red como routers y switches, aumentando el tiempo de retardo y la probabilidad de pérdida de paquetes.

- ¿Qué problemas puede causar la congestión en una red?

- Pérdida de paquetes, alta latencia, fluctuaciones en el throughput y asignación injusta de recursos.

- ¿Cómo difieren el control de congestión y el control de flujo en TCP?

- El control de flujo se enfoca en la relación emisor-receptor, mientras que el control de congestión se ocupa de la relación entre el emisor y la red.

- ¿Qué es Slow Start en TCP?

- Es un algoritmo que inicia con una ventana de congestión pequeña y la incrementa exponencialmente por cada ACK recibido.

- ¿Cuál es el propósito de Congestion Avoidance?

- Mantener el flujo de datos en un nivel sostenible para evitar la congestión, incrementando gradualmente el tamaño de la ventana de congestión.

- ¿Qué hace Fast Retransmit en TCP?

- Retransmite un segmento perdido inmediatamente al recibir tres ACKs duplicados para el mismo segmento.

- ¿Cómo funciona Fast Recovery en TCP?

- Reduce la ventana de congestión a la mitad tras una pérdida de paquetes, incrementando luego el tamaño de la ventana por cada ACK duplicado recibido.

- ¿Qué son Tahoe, Reno y NewReno en TCP?

- Son algoritmos de control de congestión que evolucionaron para mejorar la respuesta a la pérdida de paquetes.

- ¿Cómo se diferencia CUBIC de otros algoritmos de control de congestión?

- Utiliza una función cúbica para aumentar la ventana de congestión, adecuada para redes con gran capacidad de ancho de banda y alta latencia.

- ¿Qué hace especial a BBR en el control de congestión?

- Se centra en maximizar el uso del ancho de banda y minimizar la latencia, sin basarse en la detección de pérdidas.

- ¿Cómo afecta el control de congestión a las redes LAN en comparación con las WAN?

- En las LAN, donde la congestión es menos frecuente, los algoritmos de control de congestión pueden no ser tan críticos como en las WAN.

- ¿Qué desafíos presentan las redes móviles para el control de congestión de TCP?

- La variabilidad en la calidad de la señal, cambios frecuentes en las condiciones de la red y tasas de error más altas.

- ¿Qué herramientas se utilizan para monitorizar la congestión de la red?

- Herramientas como Wireshark, NetFlow, sFlow, LibreNMS, Nagios, Zabbix e Iperf/Jperf.

- ¿Cómo se puede ajustar el control de congestión en Windows y Linux?

- En Windows, a través del Editor del Registro y PowerShell; en Linux, usando sysctl y la interfaz /proc.

- ¿Qué aplicaciones prácticas tiene el control de congestión de TCP en centros de datos?

- Optimización de la gestión de tráfico y reducción de la latencia en las aplicaciones.

- ¿Qué retos actuales enfrenta el control de congestión en TCP?